AutoMLで迅速な開始と高速化を実現

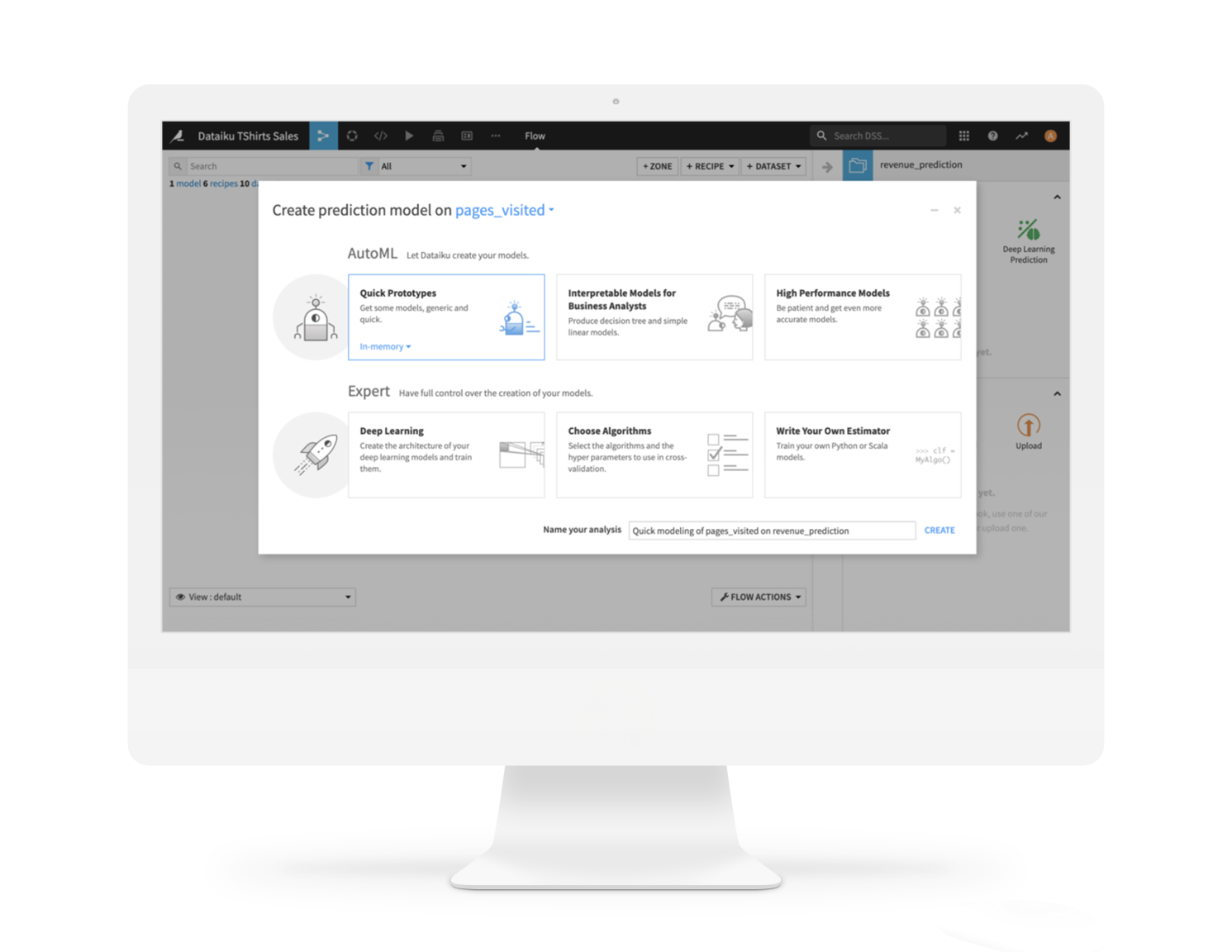

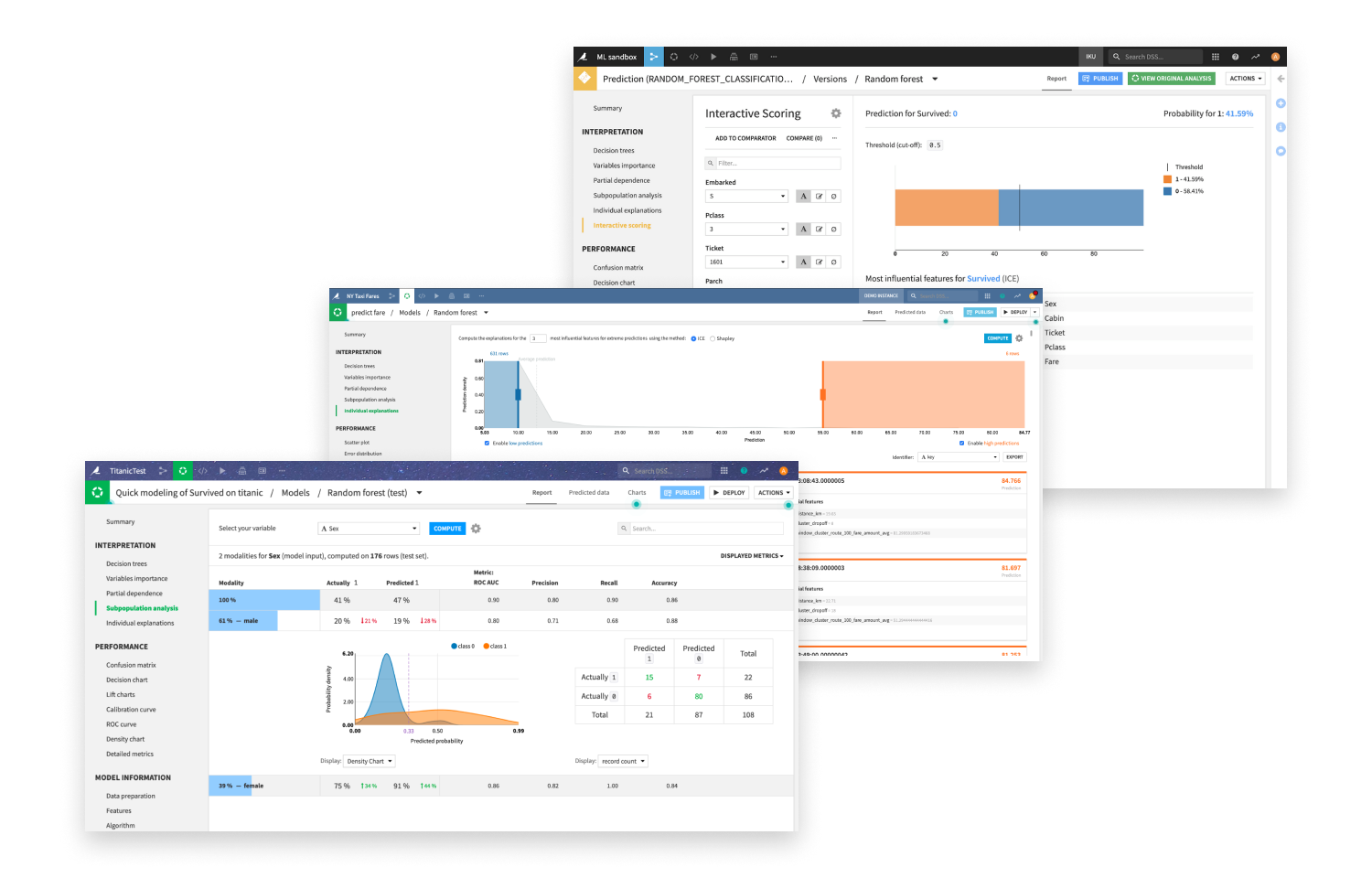

Dataikuは、迅速なプロトタイピングのためのAutoMLのシンプルさと、高度な視覚的ML機能を組み合わせ、洗練されたモデルを素早く作成できます。

予測、クラスタリング、時系列予測から因果MLやコンピュータビジョンまで、データサイエンティストもアナリストも、本番環境対応のモデルをホワイトボックスの説明可能性を備えながら、迅速に構築・比較できます。

Dive Deeper on Dataiku AutoML FeaturesDataikuは、迅速なプロトタイピングのためのAutoMLのシンプルさと、高度な視覚的ML機能を組み合わせ、洗練されたモデルを素早く作成できます。

予測、クラスタリング、時系列予測から因果MLやコンピュータビジョンまで、データサイエンティストもアナリストも、本番環境対応のモデルをホワイトボックスの説明可能性を備えながら、迅速に構築・比較できます。

Dive Deeper on Dataiku AutoML Features

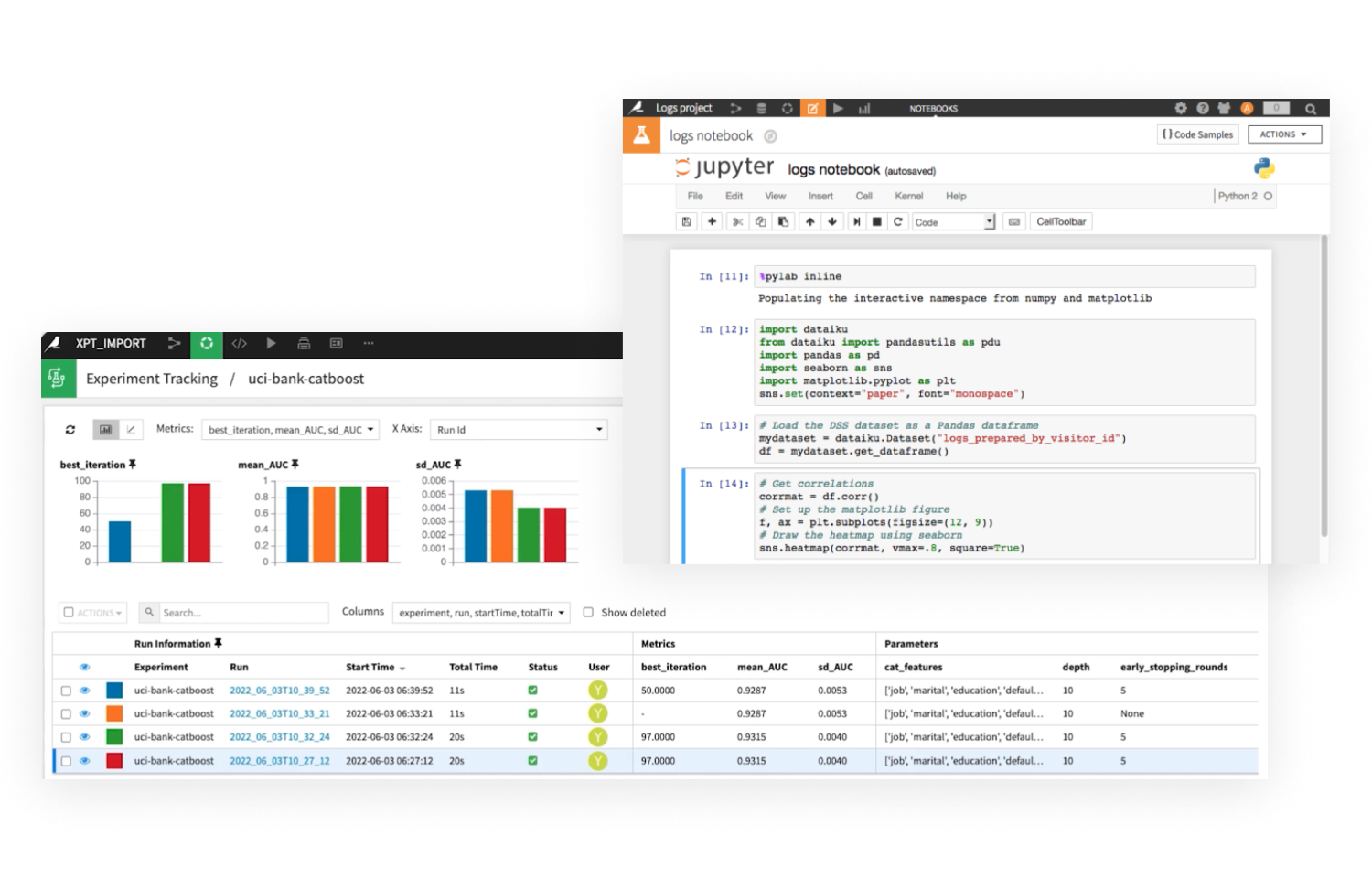

上級データサイエンティストは、プログラムによるカスタムモデルの開発(Python、Rなどの言語を使用)や、MLFlowで開発されたモデルのインポートが可能です。

外部モデルをチーム全体に可視化・解釈可能にするため、DataikuはMLFlow実験やCloudMLモデルの詳細を取得し、自動的にモデル比較と説明可能性レポートを提供します。

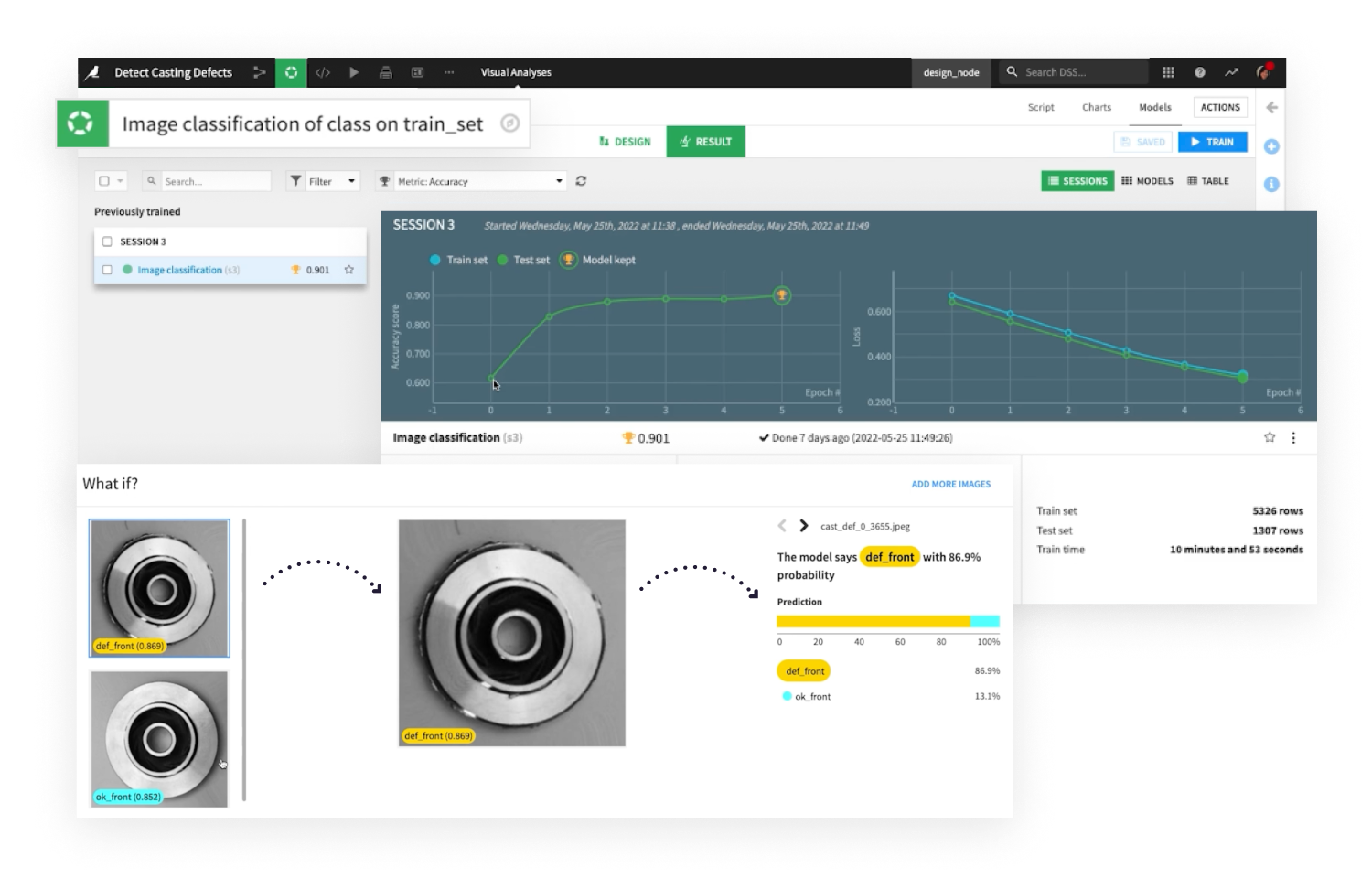

Dataikuの使い慣れたモデル設計、デプロイメント、ガバナンス体験により、データプロジェクトやビジネスアプリケーションの一部としてディープラーニングを容易に組み込めます。

KerasとTensorflowによるカスタムディープラーニングアーキテクチャの定義、または画像分類やオブジェクト検出などのコンピュータビジョンタスクのための事前学習済みモデル、転移学習、ノーコードインターフェースを活用できます。

Dataikuの堅牢な説明可能性機能により、技術者・非技術者の双方がMLモデルの結果をより深く理解できます。

公平性分析、what-if分析、ストレステストなど、インタラクティブなパフォーマンスと解釈レポートの包括的なセットを提供します。

Dataikuは、信頼性の高い高品質なMLモデルの構築だけでなく、デプロイ、モニタリング、管理に必要なすべてのツールを提供します。

モデル比較からドリフト検出、モデル再学習まで、そしてさらに多くの機能により、真のスケールでのML展開を実現します。

Learn More About MLOps With Dataiku

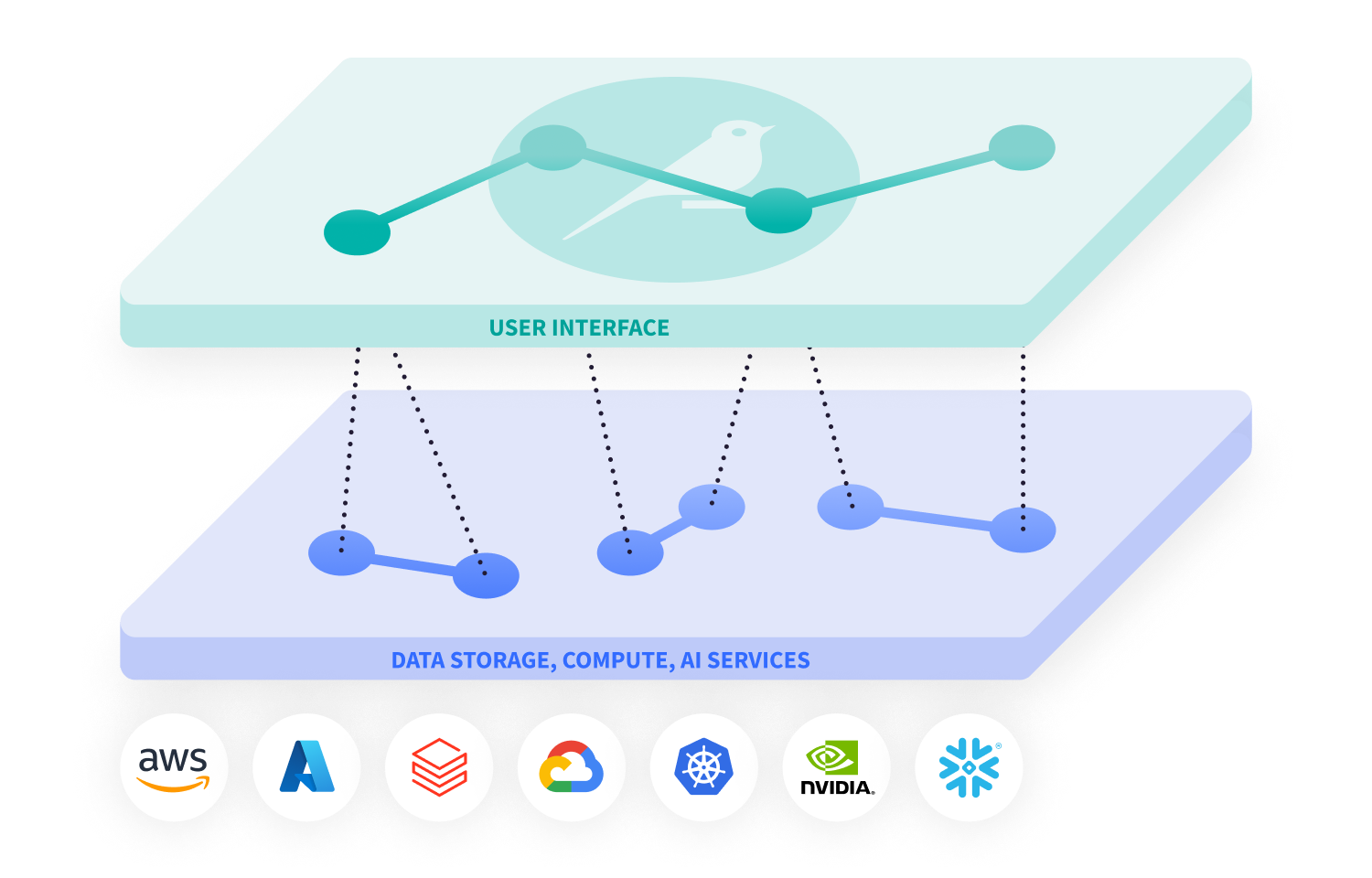

大規模な計算やモデルトレーニングジョブのために、Dataikuは選択したクラウド上でSparkとKubernetesを活用したオンデマンドの弾力的なリソースで、ワークロードを自動的かつ効率的にスケールできます。

事前設定された完全管理型クラスターがコンテナ化インフラストラクチャの複雑さを抽象化し、バックエンドリソースの設定に時間を費やすことなく、本来の作業に専念できます。

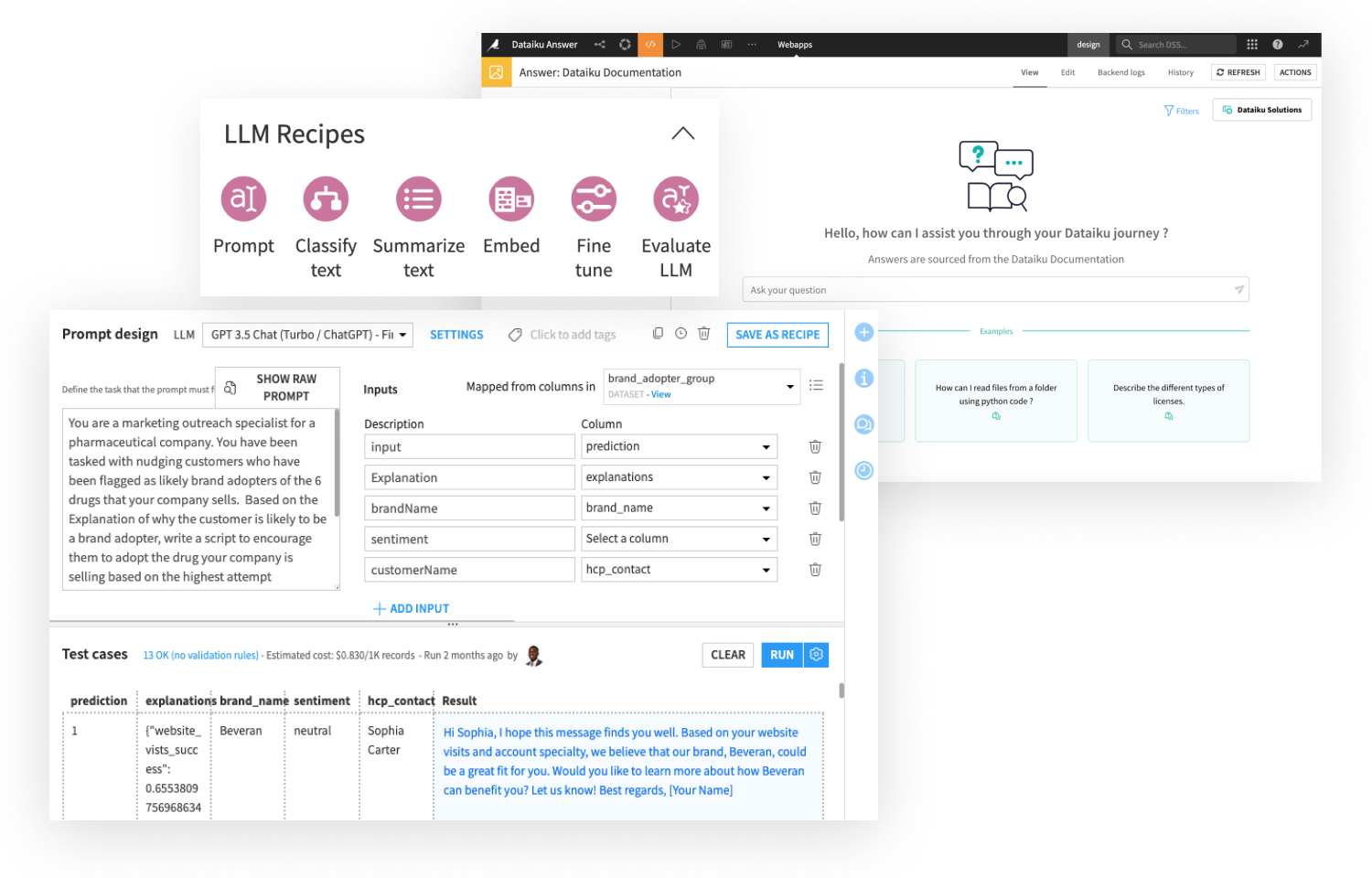

READ THE PUSHDOWN COMPUTATION BLOG POSTユニバーサルAIプラットフォームとしてのDataikuの強みは、従来のMLと生成AIベースのアプリケーションを、すべて一つの場所で構築できることです。Dataikuにおける生成AIのビルダーツールには以下が含まれます: