データ準備の包括的ガイド

データサイエンスにおけるデータ準備とは?

ツリーハウスを作ることを考えてみてください。木材やボルト、ネジが無秩序に積み上げられています。まずは整理する必要がありますよね。同じように、データも分析やモデル作成やレポートに活用する前に、適切に整理および準備する必要があります。とくに、扱うデータの規模がツリーハウスではなく、高層ビル並みになるほど、その重要性は増します。

データ準備のプロセスを理解し、その活用方法や効率化のメリットを知ることで、データアナリストはより価値の高い業務に集中できるようになります。

データ準備とは、生データを分析可能な形に整理する作業のことです。

データ分析、機械学習(ML)、生成AI(GenAI) など、あらゆるデータ活用の出発点となる重要なプロセスでありながら、手間がかかる作業でもあります。調査によると、データサイエンティストの仕事の60%以上がデータ準備に費やされていることが分かっています。

データ準備のステップ

データ準備のプロセスは企業によって異なりますが、一般的には以下のような手順で進められます。

- データ収集(Gathering): データベースにアクセスしたり、データを手動で収集し、まとめるプロセス。不要な列の削除や命名規則の調整なども含まれる。

- データクレンジング(Cleaning): データのパターンや外れ値を特定し、重複データや誤りを修正、削除する。

- データ集約(Aggregating): 粒度が細かすぎるデータを計算処理し、意味のある単位にまとめる。データセット内の特徴量を論理的にグループ化する。

- データの構造化(Structuring): データをチームの目的に合わせて整理し、ビジネスレポートなどで活用しやすい形に整える。

- データ探索(Exploring): データの特徴量やパターンを明らかにし、当初の分析目的に沿っているかを確認する。

データマイニングと呼ばれる手法が用いられる。

従来、企業はスプレッドシートやPythonなどのツールを使って手作業でデータ準備を行っていました。しかし、現在では、自動化されたデータ準備ツール の導入が進んでいます。とくに、生成AI(GenAI)を活用し、自然言語でデータ準備の指示を出せる技術が登場しており、企業の競争力を高めるために半自動化ツールや、Dataikuのような完全自動化ツールが活用されています。

なぜデータ準備が重要なのか?

データの収集やクレンジグ、集約といった作業を通じて、データの質を向上させることができます。このプロセスを適切に実行することで、分析結果の信頼性が向上し、組織全体でデータを安心して活用できるようになります。また、データの構造化やデータ探索によって、データの有用性を高めることができます。これにより、組織内のさまざまな部門がデータを活用しやすくなり、ビジネスの意思決定をサポートするための洞察を得ることができます。

データ準備における5つの一般的なミス

データ準備には、これが正解というような唯一の方法はありませんが、プロセスを明確に定義することで、データから導く洞察の質を大幅に向上させることができます。

とくに、機械学習(ML)や生成AI(GenAI) の場合、データ準備はさらに重要です。モデルの精度はトレーニングデータの質に大きく依存するため、適切なデータ準備が不可欠です。効率的なデータ準備プロセスにより、アナリストがこの重要なステップを短縮できれば、分析と洞察に多くの時間を割くことができます。

では、データ準備でよくある5つのミスとその解決策を見ていきましょう。

1. 大量のデータをスプレッドシートで処理しようとする

かつては、スプレッドシートの利用がデータ準備の定番でした。しかし、データの正確性、サイロ化された作業、セキュリティーの懸念、ヒューマンエラーなどの問題により、限界を迎えています。Dataikuが世界中のビジネスリーダー375人を対象に行った調査から、多くのビジネスリーダーが企業におけるスプレッドシートと決別したい(英語)と望んでいることが明らかになりました。この調査では、ビジネスリーダーの2人に1人がスプレッドシートに関する深刻な問題を経験していると回答しました。

解決策: スプレッドシートからエンドツーエンドのプラットフォームへ移行

ユニバーサルAIプラットフォームであるDataikuのようなエンドツーエンドのプラットフォームは、データ準備を一元化し、チームが複雑なデータセットに対してシームレスに作業できるようにします。この移行により、サイロを排除し、透明性を高め、コラボレーションを促進することができます。取り組みを1つのプラットフォームに集約し、スプレッドシートから離れること(英語)で、組織は企業レベルのデータプロジェクトを効率的に遂行することができます。

2. ユースケースの文脈を考慮しない

データの民主化は、大規模なAI活用に不可欠です。しかし、適切なドキュメントが不足していたり、データが部門ごとにサイロ化されていると、文脈(コンテキスト)の欠如が生じます。

解決策: 包括的な高度分析

DataikuのユニバーサルAIプラットフォーム は、すべてのユーザーがAIの恩恵を受けられるようにし、包括的な高度分析 を促進します。明確なドキュメントの提供やコラボレーションを支援することが、データ活用における文脈の欠如や一貫性の問題を解決します。

3. データ品質の問題を考慮しない

データ品質の問題を無視すると、誤った機械学習(ML)モデルや不正確なビジネス判断につながる可能性があります。そのため、欠損値、重複、誤ったデータなどの問題をデータ準備プロセスの早い段階で特定し、対処することが極めて重要です。

解決策: 4Cの原則と事前定義されたプロセッサー

データ品質を向上させるために、チームは 「4Cの原則」(Consistency: 一貫性、Conformity: 適合性、Completeness: 完全性、Currency: 最新性)を活用できます。また、Dataikuはプロセッサーライブラリ(英語)として、検索と置換、標準日付フォーマットへの変換、カラムの分割、カラム名の変更など、データ品質問題を効率的に処理するツールを提供します。

4. データ準備を手作業で行う(繰り返し準備する)

データ準備において、多くのチームが直面する課題の一つは、時間がかかる、エラーが発生しやすい、透明性がない、再現性がないということです。スクリプトを作成すればエラーを減らすことはできますが、柔軟性に欠け、組織全体での活用が難しい という欠点があります。

解決策: ビジュアルフローと自動化DataOpsの活用

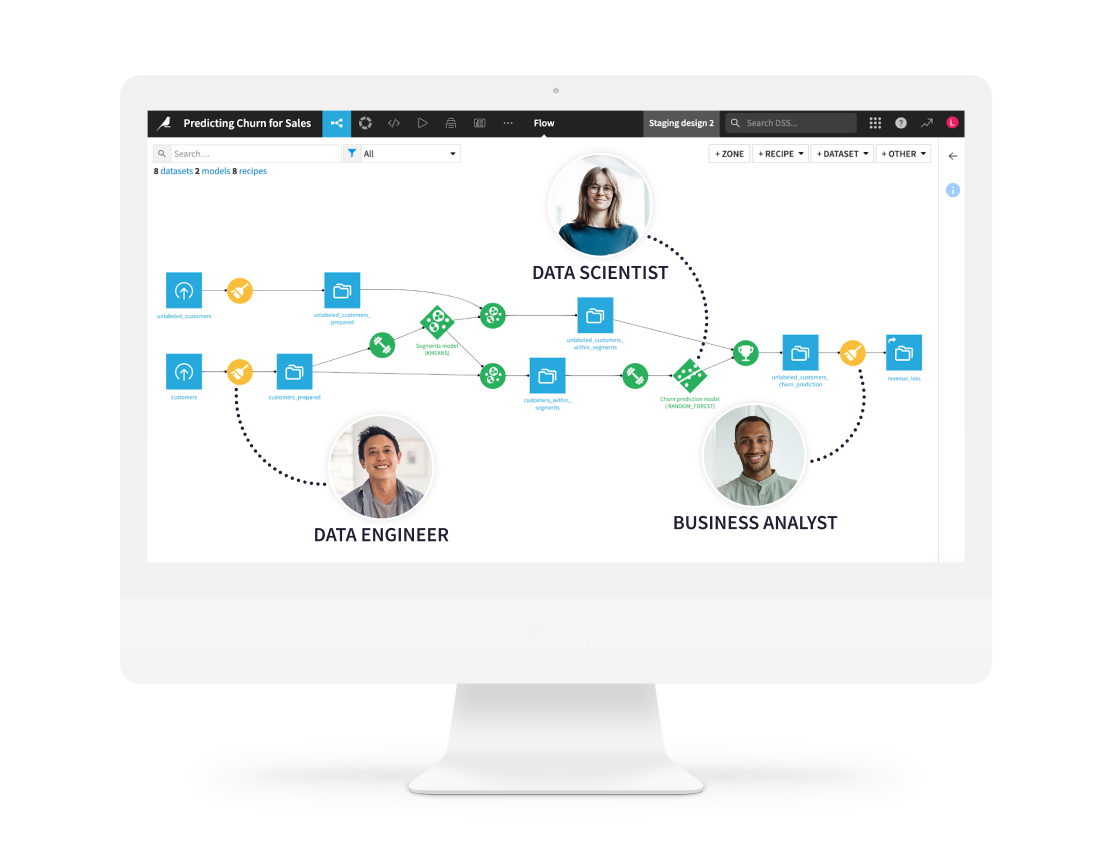

ビジュアルデータフローを活用することで、データのクリーニングや集約を効率化し、チーム全体で可視化 することが可能になります。これにより、データセットの変化に応じて柔軟に対応できるデータ準備プロセスを実現できます。ビジュアルフローが、アナリスト、データエキスパート、ビジネス担当者(SME)など、幅広いメンバーにとってアクセスしやすく理解しやすい形式で提供されれば、チーム間のコミュニケーションが円滑になります。

さらに、DataOpsを活用したデータ準備の自動化 により、特定のイベントをトリガーとしてプロセスを実行できます。これにより、時間を節約できるだけでなく、一貫性と再現性を確保し、人為的ミスを最小限に抑えることが可能になります。

5. データ準備で終わってしまう

データ準備は、AIプロジェクトの出発点に過ぎません。データの可視化や予測モデルの構築といった次のステップに進まなければ、せっかく整理されたデータの価値あるインサイトを十分に引き出せないまま終わってしまいます。

解決策: AIデータ分析でデータを最大限に活用する

Dataikuを活用すれば、ビジネスユーザーでも予測モデルを構築 したり、データ可視化ダッシュボードを作成して、貴重なインサイトを得ることが可能です。たとえば、ロジスティック回帰のためのデータ準備のように、記述分析(Descriptive Analytics)と予測分析(Predictive Analytics)を組み合わせることで、より的確な意思決定 が可能になります。

データ準備やデータ品質の確保は、機械学習やAI(生成AIを含む)を活用するデータワークフローの重要な要素です。エンドツーエンドのプラットフォームへ投資することで、高付加価値な業務に集中する時間を確保できるだけでなく、データドリブンな意思決定に対する信頼性も向上 します。さらに、生成AI(GenAI)の活用により、このプロセスがさらに一歩進化 します。

Dataikuを活用したデータ準備の目的とベストプラクティス

AIライフサイクルにおけるデータ準備フェーズの目的は、データを整理し、強化してモデル構築の入力データとして活用できる状態にすることです。すでに述べたように、データ準備は優れた機械学習モデルを構築するための重要なステップ です。より多くのデータを収集し、モデルのトレーニングに活用することで、モデルの精度を向上させることができます。また、特徴量とラベル付けを効率的に準備 することで、モデルのパフォーマンスが向上し、その結果としてビジネス価値の高い成果を得ることが可能 になります。

データライフサイクルにおける一般的なデータフローパターン

以下のデータフローパターンは、エンタープライズで広く活用されています。

- ETL(Extract, Transform, Load:抽出、変換、ロード)

- ソースシステムからデータを変換

- 関連するスキーマを適用しながらデータを準備

- データエンジニアがデータをデータウェアハウスにロードし、アナリストが簡単にアクセスできるようにする

- ELT(Extract, Load, Transform:抽出、ロード、変換)

- クラウドネイティブなデータストア(例:X)からデータを取得

- データをストリーミングし、データレイクにロード(データウェアハウスよりも大量のデータを容易に保存可能)

- データレイク上でデータを変換

データストリーム処理

近年のデータアーキテクチャーでは、データをバッチ処理するのではなく、ストリーム(連続的なデータの流れ)として扱う考え方が主流になっています。

また、データ作業のアウトプットはプロジェクトやユースケースによって異なりますが、通常、以下の3つのカテゴリに分類されます。

- データ: データを変換し、出力もデータとして生成されるケース(例:アナリストがデータをクレンジングし、整理されたExcelファイルを上司に送る)

- レポート: データを分析し、視覚的なレポートとして提供するケース(例:アナリストが上司に前四半期の業績を示す棒グラフを送る)

- モデル: データを基にアルゴリズムモデルを構築し、将来の予測や業務改善を行うケース

- エージェント: メトリクスやモデルをAIエージェントの一部としてデプロイし、最新テクノロジーをリアルタイムの意思決定やアクションの実行に利用するケース(例: AIエージェントがパフォーマンスを追跡し、最適な判断を行う。データがクレジングされていると、エージェントは高品質で、精度の高いタスク遂行が可能)

データ準備の全体的な意味や目的を理解した今、自社のデータを活用して実際に試してみたいと考えているかもしれません。データ準備を効果的に進める最もシンプルで実践的な方法の一つは、Dataikuのように、クラウド上でのデータ準備を支援する企業を活用することです。

Dataikuがどのように役立つか

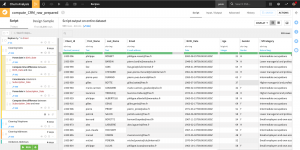

データのストレージシステムの種類に関わらず(また、アウトプットとしてデータ、レポート、モデル、エージェントのいずれを目指している場合でも)、データの準備は、Dataikuではレシピ を実行します。Dataikuのレシピとは、1つ以上の入力データセットに対して1つ以上の出力データセットを生成するために適用される、繰り返し実行可能な一連のデータ処理アクションです。

Dataikuが解決するデータ準備の課題

- 大規模データの処理: Dataikuはビッグデータ向けに設計されており、スプレッドシートの制約(シートサイズ、シートの数、カラム幅、セル内の文字数制限など)を克服できます。

- データガバナンスとAIガバナンス: すべてのデータ作業を一元管理できるプラットフォームを提供。機密情報や自社データを含むデータソースのドキュメント化をサポート。特定のプロジェクトにおいて、どのデータが使用され、誰がどのデータを「所有」しているかを確認でき、特定のプロジェクトで何が行われたかを確認し、データがどこで使用されどこから来たのかといったデータの履歴を追跡することができます。

- 機械学習: データ準備と機械学習の開発が同じ環境でできるため、プロジェクトの拡大と開発が容易になります。

- コラボレーション: Dataikuはチーム内外でのコラボレーションを促進するため、アナリストや非技術者のユーザーも、組織のデータサイエンティストやエキスパートが設定したベストプラクティスに沿って、自分自身でデータ作業を行うことができます。

- 再利用と自動化: データ準備のプロセスを一度定義すれば、レシピとして再利用が可能

データ準備の自動化により、時間とリソースを節約できます。

さらに、Dataikuのような機械学習向けのデータ準備ツール を活用することで、長期的にデータ準備の効率を向上させ、時間と労力を削減 できます。

1. 視覚的なフローとビジュアルレシピを活用して、より効果的なコラボレーションを実現する

ビジネス関係者やデータチームに分析結果を提供すると、その結果をどのように導き出したのか質問されることがよくあります。しかし、スプレッドシートやその他のデータ準備ツールを使用してデータの整理、変換、クレンジングを行ったすべての手順を説明するのは難しいものです。Dataikuは、データパイプラインの各ステップを視覚的に表現する「フロー」を自動的に生成し、どのような変換処理が行われたかを関係者に分かりやすく説明するのに役立ちます。これにより、分析の背景にある手順を理解しやすくなり、結果に対する信頼性が高まります。

Dataikuには、データのクレンジング、結合、準備を行い、ダッシュボードやビジネスレポートに活用できる多くのビジュアルレシピが用意されており、データ変換を簡単に行うことができます。Dataikuは、100種類以上のビルトインのデータ変換ツールをビジュアル形式で提供しており、データのクレンジング、結合、集計、再構成、フィルタリング、ジオコーディングなどを迅速に行えるようサポートします。

各変換を実行する前に、そのプレビューを確認することも可能です。さらに、すべての変換は個別に表示され、グループ化やラベル付けができるため、自分自身はもちろん、他のメンバーも実施された処理を完全に把握することができます。さらに嬉しいポイントとして、Dataikuはデータの意味に基づいて適切な関数を提案してくれるため、分析作業の時間を短縮できます。これらの提案は、列のヘッダーにカーソルを合わせることで確認できます。

また、スプレッドシートのような馴染みのある言語でカスタムの数式を書くことも可能ですし、必要に応じて(または希望であれば)SQLなどを使ってコードを記述し、独自の変換処理を行うこともできます。視覚的なツールを使ってスピーディに作業することも、柔軟性を求めてカスタムコードを書くことも可能です。選択はあなた次第です。

2. 自動化によって再利用の習慣を身につける

関係者向けの定期的なレポート作成では、毎回同じデータ準備の手順を繰り返すことがよくあります。こうした場合や、大量のデータを扱う際には、データ準備の作業を自動化することで、処理の迅速化に加え、一貫性、説明可能性、再現性を確保することが重要です。

Dataikuを使えば、「シナリオ」機能を活用(英語)して、これらの一般的なレポート業務の大部分を自動化することが可能です。

効率的なデータ準備は、成功するデータサイエンスの実践において不可欠です。堅牢なデータ準備プロセスに投資することで、データの品質、信頼性、アクセス性を確保し、モデルに対する信頼を築くことができます。Dataikuのような企業が提供する優れたデータ準備ツールは、データ準備の効率を高め、組織全体の業務をより効果的に支援します。よく構築されたデータ準備のフレームワークがあれば、生データを価値ある資産へと変換し、戦略的な目標を迅速かつ効果的に達成することが可能になります。

Dataikuでは、あらかじめ定義したトリガーが発生するたびに実行される一連のステップやアクションを設定することで、データ準備のプロセスを自動化することができます。トリガーは、毎日の実行のような時間ベースのものや、新しいデータのシステムへの流入、上流ジョブの完了など、他の要因に基づくものもあります。

スケジュールジョブを使えば、データクレンジングのプロセスを繰り返し自動実行できるよう簡単に設定できるため、データがデータベースに取り込まれたタイミングで自動的にクレンジングが行われます。データ準備を自動化することで、ビジネスアナリストは毎回手作業で準備作業を繰り返す必要がなくなり、既存の自動化プロセスを活用し、再利用することで大幅な時間の節約が可能になります。

アナリストが自動化を通じてデータセットのクレンジングと準備を完了したら、そのデータセットは誰もが再利用できるように共有すべきです。さらに、アナリストはデータ準備の自動化プロセス自体も保存、共有することで、作業時間と労力の節約を図るとともに、分析や結果の一貫性を維持することが重要です。

3. 組み込みのデータコネクタで必要なデータソースに簡単に接続

Dataikuでは、クラウドストレージ、オンプレミスのデータベース、エンタープライズアプリケーションなど、数十種類のデータコネクタを利用して、必要なデータへ簡単にアクセスできます。これにより、データ準備ソフトウェアの効果を最大限に引き出すことが可能です。データがどこから取得されても、すべて統一された表形式で表示されるため、スプレッドシートでのデータ準備に慣れているアナリストにとっても使いやすい設計になっています。対応しているコネクタの一覧はこちら(英語)をご覧ください。

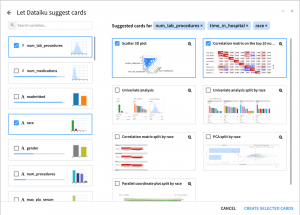

4. ネイティブのデータ可視化機能と統計分析によるメリット

データ準備のどの段階でも、25種類以上の組み込みチャートや視覚的な統計分析機能を活用することで、他のツールにデータをエクスポートすることなく、データの探索やパターンの特定を迅速に行うことができます。その後は、同じインターフェース上で機械学習モデルの作成とデプロイや、関係者向けの自動レポートダッシュボードの作成にスムーズに移行することができます。

5. 作業を共有、再利用して時間を節約

Dataikuのデータ準備機能には、再利用可能かつ共有可能なプロジェクトアセットが備わっており、過去の関連作業を簡単に見つけてナレッジを引き継ぐことができます。

レシピのコピー&ペースト、ワークフローを再利用可能なビジュアルコンポーネントとしてパッケージ化、厳選された参照データを一元化されたフィーチャーストアに公開して拡張データ準備に活用することなどが可能です。これにより、チーム全体の時間を節約し、ベストプラクティスの構築にもつながります。

データ準備に気後れする必要はありません

ご覧のとおり、アナリストは業務時間の大半をデータ準備に費やしており、それはしばしば分析の中でも最も地道で退屈な作業とされています。データ準備が好きな方でも、もう二度とデータクレンジングをしたくないという方でも、Dataikuのデータ準備機能は、その作業をより効率的に行えるよう設計されています。

よくある課題に対応し、ベストプラクティスを組み込むことで、イノベーションや競争優位性を高める大きなチャンスを手にすることができます。